Мислите ли, че хората, които създават системи за изкуствен интелект, получават достатъчно образование по етика в университетите?

Не съм сигурен, че етиката е нещо, което може да се преподава Тя е нещо, което може да се научи. Нямам отговор как може да стане това. Не мисля, че с онлайн курсовете, в които се говори по тази тема за 1 час, това може да се получи. Всеки програмист, който прави софтуер, трябва да има отговорност. Но според мен програмите трябва да се тестват от хора, които не са програмисти. Понякога програмистите се центрират върху технически неща и не се замислят върху неща, които могат да се случат в действителност. Аз съм голям фен на това хора от различни специалности да дават своята гледна точка за някоя технология. Това може да роди много и различни решения на един и същ проблем. От друга страна, нито един софтуерен разработчик не може да предвиди всички последствия,

които могат да се случат от изпозването на един софтуер или една технология. Затова производителите пишат дълги листовки и казват на хората какво да не правят. Да се учи с примери, е много по-продуктивно. Ние трябва да обучаваме етика по този начин. Все повече компании се интересуват от кандидати, които имат отношение към етичната страна и отговорността на технологиите.

Преди няколко години се появи нов клон на знанието – технологията за обществен интерес. Това е приложна технология, която търси социално отговорни решения за предизвикателствата, пред които ни изправят някои от иновациите.

Това ми дава надежда. Сега много хора използват технологиите безкритично, без дори да се замислят и да осъзнават, че тези технологии могат да правят грешки и да са уязвими. Аз се надявам потребителите на интернет да чувстват подтик да проверяват откъде идва информацията не само когато очевидни грешки, като в моя некролог, ги карат да правят това. Надявам се по-често да мислят критично и да започнат да се питат: откъде идва тази информация, има ли потвърждение на твърденията, които получавам. Искам хората да изпитват нужда да валидират тази информация. Понеже някои от ботовете се обучават на базата на това, което се разпространява в интернет, това може да доведе до ограничаване на тази информация, което ще елиминира интернет като място за споделяне на полезна информация .

Германски фотограф върна награда за снимка, която не е направил

Имаме право да знаем кога изкуствен интелект е участвал във вземането на решения.

Германският фотограф Борис Елдагсен отказа престижното отличие Sony World Photo Award с мотива, че наградата му е присъдена за снимка, която не е направил. „Използвах изкуствен интелект, за да генерирам спечелилата снимка", призна фотографът.

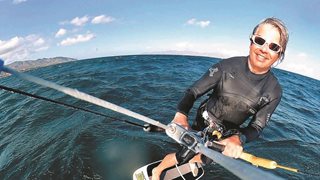

„Това беше тест, за да се види дали конкурсите са подготвени за ерата на AI. Не са!", казва по този повод Хенри Айдер през European Science-Media Hub. Айдер съветва правителства и компании, сред които Adobe, Meta и Европейската комисия, за въздействието на AI върху бизнеса и обществото, а също води радиопоредица в BBC, с която образова аудиторията за т. нар. deep fake – генерирането на фалшиво аудио и видеосъдържание – тоест думи, които човек не е изричал.

Според Айдер ни е нужен баланс между вълнението от възможностите, които изкуственият интелект предлага, и осъзнаването, че той не е перфектен и се нуждае от внимателно наблюдение. „В момента сферата на изкуствения интелект е малко като Дивия запад. „Не искаме да го демонизираме изцяло – той има много невероятни приложения. Но са нужни регулации, които да определят къде трябва човек да знае, че изкуствен интелект е участвал във вземане на решение или е генерирал съдържание", обяснява Айдер.

За съжаление обаче, повечето продукти, базирани на AI, не са прозрачни. „Те са черни кутии, създадени от разработчици. Как мога да се доверя на софтуер, за който никой освен неговия производител не знае как работи?", пита се Айдер. Според него вече е сериозен проблем, ако софтуер, базиран на изкуствен интелект, дава правилен резултат само в 90 процента от случаите. Това може да се дължи на данните, използвани за обучение, които съдържат имплицитни отклонения, или е имало намеса от страна на хора. В крайна сметка хората са тези, които трябва да поемат отговорност за всяко решение, взето от AI, смята Айдер.

Коментари (0)

Вашият коментар